NVIDIA DGX Systeme bieten die weltweit führenden Lösungen für skalierbare KI-Infrastrukturen im Unternehmensumfeld. Sie bestehen aus einer leistungsstarken Kombination aus GPU-optimierter Software, maximaler Leistung und vereinfachtem Management.

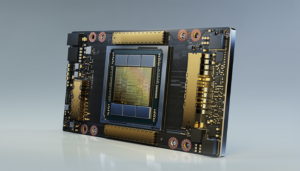

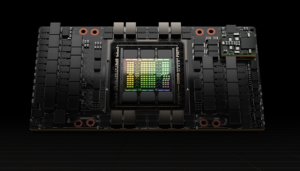

NVIDIA verfügt über ein breites Portfolio an Grafikprozessoren – von der Einstiegs- über die Mainstream- bis hin zur höchsten Leistungsstufe. Jeder dieser Prozessoren bietet die Vielseitigkeit, um unterschiedlichste KI-Anwendungen zu beschleunigen, egal ob am Endgerät oder in der Cloud. Neben Ampere bietet NVIDIA seit 2022 ihre neue Enterprise GPU H100 auf Basis der Hopper-Architektur an, deren Fokus stärker denn je auf KI und Machine Learning liegt.

80 Milliarden Transistoren und Tensor-Kerne der vierten Generation sorgen u.a. für wesentlich mehr Leistung und Geschwindigkeiten, die die der A100 um das bis zu sechsfache übertreffen. In Kombination mit dem NVIDIA NVLink Switch System können bis zu 256 H100 verbunden werden, um Exascale Workloads zu beschleunigen, während die dedizierte Transformer Engine Billionen-Parameter-Sprachmodelle unterstützt. Zusammen mit InfiniBand-Interconnect bietet H100 für die heutigen Mainstream-KI- und HPC-Modelle eine bis zu 30-fache Leistung im Vergleich zu A100.

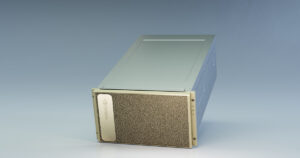

Der NVIDIA DGX SuperPOD ist eine KI-Infrastrukturplattform für Rechenzentren, die es ermöglicht, Leistung ohne Kompromisse für alle Benutzer und die anspruchsvollsten KI- und HPC-Workloads (High Performance Computing) bereitzustellen. Unternehmen profitieren von einer beschleunigten Infrastruktur sowie einer agilen, skalierbaren Leistung und haben so die Möglichkeit, KI so einfach wie möglich in alle Geschäftsbereiche zu integrieren.

Der DGX SuperPOD wird in zwei Modi angeboten – mit NVIDIA DGX A100-Systemen oder DGX H100-Systemen.

DGX A100

Die dritte Generation des fortschrittlichen KI-Systems vereinheitlicht alle KI-Workloads in einer Lösung. Es eignet sich besonders für skalierte Infrastrukturen, die große Teams bei verschiedenen KI-Workloads unterstützen sollen: zum Beispiel für die Optimierung von Lieferketten oder den Erkenntnisgewinn aus großen Datenmengen.

DGX H100

Die neueste Version der NVIDIA DGX Systeme ist das KI-Kraftpaket, das durch die hohe Leistung der NVIDIA H100 Tensor Core-GPU beschleunigt wird. Es eignet sich besonders für skalierte Infrastrukturen, die auf große und komplexe KI-Workloads ausgelegt sind: zum Beispiel große Sprachmodelle mit NVIDIA NeMo Megatron und Deep Learning-Empfehlungssysteme.

AI Enterprise

Die End-to-End-Plattform beschleunigt die Data-Science-Pipeline und unterstützt die Entwicklung und Bereitstellung von prädiktiven KI-Modellen, um wichtige Prozesse zu automatisieren und schnell Erkenntnisse zu gewinnen.

Zugang zu KI-Expertise

Die NVIDIA DGXperts, ein globales Team von mehr als 22.000 KI-Experten, verfügen über mehr als 10 Jahre Erfahrung und stehen Ihnen beratend zur Seite.

Base Command Platform

Der Softwaredienst verwaltet den gesamten Lebenszyklus des KI-Trainings – inkl. Workload-Management, Ressourcensharing sowie integrierte Überwachungs- und Berichts-Dashboards.

Base Command

NVIDIA Base Command unterstützt jedes NVIDIA DGX-System und macht es schneller, einfacher und günstiger, den ROI einer KI-Infrastruktur zu realisieren.

Für den Betrieb einer eigenen KI-Lösung benötigen Unternehmen viele Ressourcen und Fachwissen. Die NVIDIA DGX Cloud-Lösung bietet Unternehmen einen einfacheren Einstieg, ohne dass hohe Investments in die Infrastruktur und Personal getätigt werden müssen. Der Service beinhaltet KI-Modelle, leistungsstarke KI-Infrastrukturen in verschiedenen Leistungsstufen, NVIDIA AI Enterprise sowie dazugehörigen Support durch KI-Experten.

Erfahren Sie mehr über die NVIDIA DGX Cloud und den praktischen Einsatz bei unseren Kunden in unserem CANCOM.info Artikel.